Allgemeine Informationen

Definition

- Die Qualität einer Therapiestudie wird ausgehend vom Studiendesign und der Generalisierbarkeit der Studie beurteilt.

- Die Validität dient der Beurteilung, ob die Studie zutreffende Schlussfolgerungen liefert.

- interne Validität (Glaubwürdigkeit)

- externe Validität (Übertragbarkeit)

Studiendesign

Validitätskriterien für Therapieversuche

1. Handelt es sich um eine kontrollierte Studie?

- Verbesserung der Aussagekraft von Therapiestudien durch Kontrollgruppe (aktive Kontrolle, historische Kontrolle, Placebokontrolle)3

- Vergleich der neuen Therapie mit einem Placebo oder mit einer Therapie, die als Standardbehandlung gilt?

- Vor allem bei der Untersuchung neuer Therapiemethoden ist ein Vergleich mit Placebo sinnvoll.

- Einsatz von Placebo ethisch vertretbar, wenn keine Standardtherapie vorhanden.4

- Bei schwerwiegenden Erkrankungen mit etablierter Behandlung ist ein Vergleich mit Placebo ethisch nicht vertretbar.

- In diesem Fall ist ein Vergleich mit der Standardtherapie sinnvoll.

- Vor allem bei der Untersuchung neuer Therapiemethoden ist ein Vergleich mit Placebo sinnvoll.

- Wahl der Kontrollgruppe sollte genau beschrieben sein.3

- Vergleichbarkeit der Interventionsgruppe und der Kontrollgruppe ohne systematische Abweichungen?

2. War die Verteilung der Patient*innen auf die Behandlungen randomisiert?

- Zentrale Anforderung für die Anerkennung als Qualitätsstudie

- Verteilung der Patient*innen auf Interventions- und Kontrollgruppen nach dem Zufallsprinzip (Randomisierung)

- Für jede Patientin/jeden Patient somit gleiche Wahrscheinlichkeit, der Interventions- oder der Kontrollgruppe anzugehören.

- Randomisierte, kontrollierte Studien sind Goldstandard für den Beleg von Wirksamkeit und Sicherheit einer neuen Therapie.4

- Durch Randomisierung gleichmäßige Verteilung von Einflussfaktoren wie Risikofaktoren und Komorbiditäten auf die Studienruppen5

- Randomisierung gewährleistet verzerrungsfreie Schätzung des Behandlungsunterschieds und die Validität statistischer Tests bei der Auswertung der Studie.2

- Zufallsverteilung durch Verwendung von Zufallszahlen oder Computeralgorithmen5

3. Gingen alle Patient*innen, die in der Studie inkludiert waren, in die Schlussauswertung ein?

- War das Follow-up abgeschlossen?

- Sog. „Drop-outs“ sind Patient*innen mit Einwilligung zur Studienteilnahme, die aus unterschiedlichen Gründen aus der Studie ausgeschieden sind.2

- Jede Person kann die Studie freiwillig verlassen ohne Verpflichtung, dies zu begründen.

- Viele Drop-outs können die Gültigkeit der Studienergebnisse beeinträchtigen.

- „Lost-to-follow-up“ sind Patient*innen, bei denen der Kontakt im Follow-up-Zeitraum nicht aufrechterhalten werden konnte.2

- Kritisch sind vor allem Patient*innen, bei denen ein besonders guter oder besonders schlechter Gesundheitszustand für ein „Lost-to-follow-up“ verantwortlich sind.2

- Patient*in sieht aufgrund einer deutlichen Zustandsbesserung keinen Grund mehr für weitere Kontrollen.

- Falls Patient*in im Therapiearm, würde dies zu einer Unterschätzung der Wirksamkeit der Therapie führen.

- Patient*in verliert aufgrund einer Zustandsverschlechterung das Vertrauen in die Studie.

- Kritisch sind vor allem Patient*innen, bei denen ein besonders guter oder besonders schlechter Gesundheitszustand für ein „Lost-to-follow-up“ verantwortlich sind.2

- Drop-outs sollten detailliert beschrieben werden:

- Wie viele Patient*innen in welcher Gruppe?

- Unterscheiden sich diese Patient*innen von denen, die die Studie beenden?

- Die Analyse der Ergebnisse muss die Patient*innen, die ausfallen, mit berücksichtigen.6

- Auswertung mit Drop-outs („Intention-to-treat“)

- Auswertung ohne Drop-outs („According to Protocol“).

- In Therapiestudien hohe Anforderungen an die Vollständigkeit des Follow-ups zum Ausschluss einer systematischen Verzerrung2

4. Wurden die Patient*innen in den Gruppen, in die sie randomisiert wurden, analysiert?

- Anhaltspunkte, dass die Zusammensetzung der Patientengruppen manipuliert wurde?

- Für die Leser*innen eines wissenschaftlichen Artikels kaum zu erkennen.

- Die Beurteilung ist Aufgabe der Gutachter*innen vor der Veröffentlichung.

5. Wurde die Studie verblindet durchgeführt?

- Man spricht von Verblindung, wenn folgende Personen nicht über die individuelle Behandlungszuteilung der Studienpatienten informiert sind:2

- Prüfärzt*innen

- Pfegepersonal

- teilnehmende Patient*innen

- zuständige Personen für: Monitoring, Datenmanagement, Auswertung der Studie.

- Arten der Verblindung2

- Doppel-blinde Studie: Weder Patient*in noch Prüfärzt*in wissen, welche Therapie die Patient*in erhält (dies gilt für die meisten Medikamentenstudien).

- Einfach-blinde Studie: Nur Patient*in (oder nur der Prüfärzt*in) ist verblindet.

- offene Studie: keine Verblindung

- In einigen Fällen ist das „Double-Dummy“-Verfahren notwendig, z. B. beim Vergleich zweier aktiver Therapien.2

- jede aktive Therapie mit identischem Placebo

- Jede Studiengruppe erhält sowohl ein aktives Medikament als auch ein Placebo.

6. Waren die Gruppen zu Beginn des Versuchs gleich beschaffen?

- Demografische Daten der Patient*innen und sonstige Messvariablen sollten im Rahmen der deskriptiven Statistik tabellarisch und/oder grafisch übersichtlich dargestellt sein.

- An der Darstellung der Daten ist häufig schon erkennbar, ob die Daten richtig und fachgemäß erfasst und ausgewertet wurden.7

- Normalerweise wird durch Randomisierung eine Gleichverteilung der unterschiedlichen Variablen in den Patientengruppen gewährleistet.

- Gefahr einer Nicht-Gleichverteilung trotz Randomisierung vor allem bei kleinen Studien mit relativ wenigen Patient*innen

- Abgesehen von der Intervention, wurden die Versuchspersonen gleich behandelt?

- Die Behandlung der Gruppen sollte sich nur hinsichtlich der zu untersuchenden Therapie unterscheiden und in allen anderen Behandlungs- und Betreuungsmodalitäten gleich sein.

- Dies wird vor allem durch die (Doppel-)Verblindung erreicht.

Ergänzende Kommentare

- Unkontrollierte Studie

- Die Behandlung wird nicht mit einer Kontrolle verglichen.

- Offene Studie

- Im Gegensatz zu einer verblindeten Studie wissen sowohl Patient*in als auch Ärzt*in, welche Behandlung Patient*in erhält.

- Unkontrollierte offene Studie

- Eine Probebehandlung („Versuchen Sie es damit und wir sehen, wie es wirkt“) kann als unkontrollierte offene Studie betrachtet werden.

- Mögliche Erklärungen für eine Besserung des Gesundheitszustands

- pharmakologische Eigenschaften des geprüften Arzneimittels

- Andere Elemente der Gesamtbehandlung, die zu einer Besserung führen.

- Placebo-Effekt: Die Wirkung beruht auf dem Glauben an die Wirksamkeit der Behandlung.

- Spontanheilung

- Änderungen des Lebensstils, Ernährungsumstellung, tägliche Routinen etc., die eine Besserung der Erkrankung zur Folge haben.

- „Minimal clinically important difference“

- Festlegung vor Studienbeginn, welches der geringste Therapieeffekt mit klinischer Bedeutung ist.

Ergebnisse

- Wie groß war der Behandlungseffekt?

- Es werden viele verschiedene Effektmaße verwendet, z. B.:

- relatives Risiko (RR)

- relative Risiko-Reduktion (RRR)

- absolute Risikoreduktion (ARR)

- Quotenverhältnis (OR).

- Die Signifikanzberechnungen entscheiden, ob die Ergebnisunterschiede statistisch bedeutsam sind oder nicht.

- Der p-Wert basiert auf der Nullhypothese. Er sagt etwas über die Wahrscheinlichkeit aus, das jeweilige Ergebnis rein zufällig zu erreichen, vorausgesetzt, es gibt keinen Unterschied (Nullhypothese) in den beiden verglichenen Populationen.

- Das Konfidenzintervall ist der Vertrauensbereich, in dem der wahre Wert mit einer gewissen Wahrscheinlichkeit (z. B. 95 %) liegt. Wenn das gesamte Konfidenzintervall außerhalb des 0-Wertes liegt, gilt das Ergebnis als statistisch signifikant.

Ergebnismaß

- Beispiel einer Studie, in der 20 % (0,20) in der Kontrollgruppe starben, während es in der Gruppe mit Behandlung nur 15 % (0,15) waren.

- Basisrisiko

- Das Basisrisiko ist das Risiko, das bei der jeweiligen Person für ein Ereignis besteht, vorausgesetzt, diese Person wird nicht behandelt.

- Im Beispiel läge das Basisrisiko bei 20 %.

- Absolute Risikoreduktion (ARR)

- Absoluter Unterschied (die Differenz) zwischen dem Anteil, der in der Kontrollgruppe starb (X) und dem Anteil, der in der Behandlungsgruppe starb (Y).

- X ‒ Y = absolute Risikoreduktion = 0,20 ‒ 0,15 = 0,05 oder 5 %

- Relatives Risiko (RR)

- Eine andere Möglichkeit, die Wirkung der Behandlung auszudrücken, ist das relative Risiko. Dies bezeichnet das Risiko für ein Ereignis bei Patient*innen, die die neue Behandlung erhalten, relativ zum Risiko in der Kontrollgruppe:

- Y / X = relatives Risiko = 0,15 / 0,20 = 0,75 oder 75 %

- Relative Risikoreduktion (RRR)

- Ein häufiges Verfahren zur Beschreibung von Behandlungseffekten ist die sog. relative Risikoreduktion (RRR). Sie wird als Prozentsatz ausgedrückt:

- [1 ‒ Y / X] x 100 % = relative Risikoreduktion = [1 ‒ 0,75] x 100 % = 25 %

- Eine RRR von 25 % bedeutet, dass die neue Behandlung das Todesrisiko im Vergleich zur Kontrollgruppe um 25 % reduziert. Je höher die RRR, desto wirksamer ist die Behandlung.

Anzahl der notwendigen Behandlungen (NNT)

- Beispielsweise beträgt die absolute Risikoreduktion für Tod 2,5 %.

- Der Kehrwert (1 / 0,025) entspricht der Anzahl der zu behandelnden Patient*innen, um einen Todesfall zu vermeiden (NNT = Number Needed to Treat).

- NNT = 1 / absolute Risikoreduktion = 1 / 0,025 = 40

- Das bedeutet, 40 Patient*innen müssen behandelt werden, um 1 Todesfall zu vermeiden.

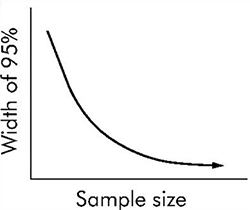

Größe der Studie

- Die Zahl der Patient*innen in einer Studie („Stichprobenumfang“) ist mit entscheidend für die Zuverlässigkeit der erreichten Ergebnisse.

- je mehr Patient*innen, desto sicherer das Ergebnis, desto kleiner das Konfidenzintervall

- Weist eine Studie keinen statistisch signifikanten Effekt nach (z. B. p < 0,05), kann die Erklärung sein:

- Es gibt tatsächlich keinen Unterschied in der Wirkung – oder –

- die Studie war zu klein, sodass tatsächliche Unterschiede keine statistische Signifikanz erreichen.

- Je größer die Studie desto kleiner ist der Standardfehler (SE = Standard Error) und desto kleiner das Konfidenzintervall.

- Konfidenzintervall = ± 1,96 SE

- Andererseits:

- Je größer die Studie und je mehr Patient*innen desto schwieriger und anspruchsvoller ist die Durchführung der Studie.

Studiengröße und Größe des Vertrauensintervalls

Statistische Maße

- Statistische Tests dienen der Entscheidung, ob ein evtl. Unterschied in der Wirkung zweier Behandlungen zufällig sein könnte.

- Die Berechnung der statistischen Signifikanz geht davon aus, dass es unter den Behandlungen keinen Unterschied gibt (Nullhypothese).

- p-Wert und Konfidenzintervall sind statistische Wahrscheinlichkeitsmaße (relativ komplexe mathematische Formeln), die verwendet werden, um z. B. die Wirkung von zwei verschiedenen Behandlungen auf zwei Populationen zu vergleichen.

- Wie hoch ist die Wahrscheinlichkeit für Unterschiede in der Wirkung?

- p-Wert

- Der p-Wert ermöglicht in Studien die Entscheidung zur Verwerfung oder Beibehaltung der vorab formulierten Nullhypothese (z. B. „Es gibt keinen Unterschied zwischen den beiden Behandlungen.“).8

- Ein kleiner p-Wert bedeutet, dass die Wahrscheinlichkeit für einen zufälligen Unterschied gering ist.8

- Bei einem p-Wert von < 0,05 beträgt die Wahrscheinlichkeit für einen zufälligen Unterschied weniger als 5 %, bei einem p-Wert < 0,01 weniger als 1 %.

- Das Signifikanzniveau, ab dem eine Unterschied als statistisch signifikant betrachtet wird, sollte vorab festgelegt werden.

- In vielen Studien gilt ein Unterschied bei einem p-Wert < 0,05 als statistisch signifikant, d. h. die Nullhypothese wird verworfen.

- Je größer die Studienpopulation ist, desto eher können auch sehr niedrige p-Werte erzielt werden, die Nullhypothese wird dann dementsprechend sehr unwahrscheinlich.

- Bei einer großen Studiengruppe können auch sehr kleine absolute Unterschiede als statistisch signifikant erkannt werden.

- p-Werte allein ermöglichen keine Aussage über die Richtung oder Größe eines Behandlungsunterschieds oder das relative Risiko, Konfidenzintervalle geben hier mehr Informationen.8

- Bei Studien mit zahlreichen getesteten Hypothesen entsteht das Problem des multiplen Testens: z. B. ist bei 20 Tests mit Signifikanzniveau 5 % ein zufälliger p-Wert unter 0,05 zu erwarten.9

- Es sollte daher möglichst ein Hauptzielkriterium vorab definiert sein.9

- Konfidenzintervall

- Konfidenzintervall oder Vertrauensbereich ist ein mit statistischen Verfahren berechneter Bereich, der den gesuchten wahren Wert (z. B. Differenz zweier Mittelwerte) mit einer gewissen Wahrscheinlichkeit überdeckt.8

- Die gewählte Wahrscheinlichkeit (Konfidenzniveau) beträgt meistens 95 %.

- Wiederholt man die Studie 20-mal, liegt der wahre Wert 19-mal innerhalb des errechneten Konfidenzintervalls.

- Konfidenzintervalle geben anders als der p-Wert Informationen über Größe, Richtung und Streuung der untersuchten Behandlungswirkung.8

- Schließt das Konfidenzintervall den Wert der Nullhypothese ein (z. B. 0 für den Unterschied zweier Mittelwerte oder 1 für das relative Risiko), liegt ein nichtsignifikantes Ergebnis vor (korrespondierend zu p > 0,05).

- Liegt das Konfidenzintervall insgesamt auf einer Seite des „Kein-Unterschied“-Wertes, bedeutet dies einen signifikanten Unterschied.

- Das Konfidenzinervall ermöglicht eine bessere Einordnung des Ergebnisses bei fehlender statistischer Signifikanz (p > 0,05), z. B. wenn das KI von –5 % bis +40 % reicht.

- Das Konfidenzintervall wird beeinflusst durch:

- Streuung der Messwerte

- Wahl des Konfidenzniveaus (in den meisten Studien 95 %)

- Größe der Studienpopulation.

- Ein großes Konfidenzintervall entsteht durch starke Streuung der Messungen, hohes Konfidenzniveau oder kleine Studienpopulation.8

Klinische Signifikanz

- Statistische Signifikanz bedeutet nicht automatisch klinische Signifikanz.

- Auch ein sehr kleiner absoluter Unterschied mit fraglicher klinischer Relevanz kann statistisch signifikant sein.

- Der gleiche absolute Unterschied kann bei großer Studienpopulation statistisch signifikant und bei kleiner Population statistisch nicht signifikant sein.

- Die klinische Signifikanz beinhaltet ein klinisches Ermessen: Ist der beobachtete Unterschied so groß, dass er von praktischer Bedeutung ist?

- Forscher*innen, Journals und Leser*innen sollten klinisch möglicherweise relevante Ergebnisse nicht nur deshalb ignorieren, weil der p-Wert keine statistische Signifikanz anzeigt.8

Teststärke und Fallzahlanalyse

- Die Teststärke, oder „Power“, ist die Wahrscheinlichkeit vor Beginn der Studie, den tatsächlichen Unterschied mit dem verwendeten statistischen Test aufzudecken.10

- Die Power wird häufig auf 80 oder 90 % festgelegt.2

- Die Teststärke berechnet sich aus folgenden 4 Faktoren:

- Klinisch relevanter Mindestunterschied, der nachgewiesen werden soll.

- Varianz der Ergebnisse (bei Studien mit kontinuierlichen Ergebnisvariablen)

- Signifikanzniveau des Tests

- Anzahl der Patient*innen.

- Fallzahlplanung vor Studienbeginn ist wichtig, da weder zu kleine noch zu große Studien ethisch und ökonmisch zu rechtfertigen sind.10

- Bei zu kleinen Studien kann evtl. ein tatsächlich vorhandener Unterschied nicht statistisch signifikant nachgewiesen werden.

- Bei zu großen Studien werden unnötig viele Patient*innen einem evtl. Behandlungsrisiko ausgesetzt.

- Für die Fallzahlanalyse, z. B. für eine Studie hinsichtlich der Wirkung eines Medikaments auf die Hospitalmortalität nach Herzinfarkt, wird vorab festgelegt:2

- klinisch relevante Verringerung der Mortalität, z. B. um 8 %

- Signifikanzniveau der verwendeten statistschen Tests, z. B. 5 %

- Teststärke (Power), z. B. 80 %.

- Ziel der Fallzahlplanung ist die Ermittlung eines Stichprobenumfangs, mit dem eine tätsächlich vorhandene Wirkiung einer Behandlung mit hoher Wahrscheinlichkeit als statistisch signifikant ermittelt wird.10

- Es widerspricht der wissenschaftlichen Ethik, die Teststärke nach Ausführung der Studie zu berechnen.

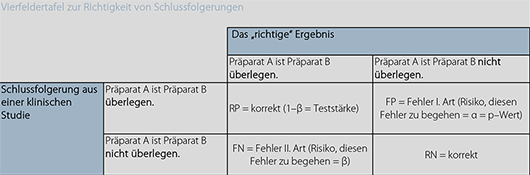

Typ-I- und Typ-II-Fehler

- Bei einem statistischen Testverfahren sind zwei Fehler möglich:2

- Die Nullhypothese wird verworfen, obwohl sie richtig ist (Typ-I-Fehler).

- Die Nullhypothese wird beibehalten, obwohl sie falsch ist (Typ-II-Fehler).

- Die Wahrscheinlichkeit für einen Typ-I-Fehler entspricht dem gewählten Signifikanzniveau α (häufig 5 %).

- Die Wahrscheinlichkeit für den Typ-II-Fehler β wird in einem statistischen Test nicht kontrolliert und kann Werte bis zu 1-α annehmen.2

- je kleiner die Stichprobe desto größer die Wahrscheinlichkeit für einen Typ-II-Fehler2

Generalisierbarkeit

- Auf wen sind die Ergebnisse anwendbar?

- Sind die Patient*innen, die an der Studie teilgenommen haben, denen aus dem klinischen Alltag ähnlich?

- Einschlusskriterien: Wer hat an der Studie teilgenommen?

- Ausschlusskriterien: Wer hat nicht an der Studie teilgenommen?

- Können die Ergebnisse in meiner klinischen Praxis angewendet werden?

- Wurden gute Maße für die Wirksamkeit der Behandlung benutzt?

- Nachteile der neuen Behandlung

- Gibt es bei der neuen Behandlung Nachteile, z. B. Nebenwirkungen, Komplikationen?

- Sind die wahrscheinlichen Vorteile der Behandlung die möglichen Nebenwirkungen und Kosten wert?

- Zu welchem Schluss kommen Sie, wenn Sie alle Vorteile und Nachteile der neuen Behandlung gegeneinander abwägen?

Quellen

Links

- The NNT Group: Quick summaries of evidence based medicine. Therapy (NNT) Reviews. NNT

Literatur

- Cochrane Deutschland. Cochrane Glossar: Validität. www.cochrane.de

- Schumacher M, Schulgen G. Methodik klinischer Studien. Berlin Heidelberg: Springer, 2002. link.springer.com

- du Prel J, Röhrig B, Blettner M. Kritisches Lesen wissenschaftlicher Artikel. Dtsch Arztebl Int 2009; 106: 100-105. doi:10.3238/arztebl.2009.0100 DOI

- Kabisch M, Ruckes C, Seibert-Grafe M. Randomized controlled trials: part 17 of a series on evaluation of scientific publications. Dtsch Arztebl Int 2011; 108: 663-668. doi:10.3238/arztebl.2011.0663 DOI

- Röhrig B, du Prel J, Wachtlin D, et al. Studientypen in der medizinischen Forschung. Dtsch Arztebl Int 2009; 106: 262-268. doi:10.3238/arztebl.2009.0262 DOI

- Gawlik C, 1, Abholz H, Burkhard B, et al. Beurteilung klinischer Therapiestudien - Mindeststandards für den Arbeitsalltag. Dt Ärztebl 1998; 95: A1155-1160. www.aerzteblatt.de

- Spriestersbach A, Röhrig B, du Prel J. Deskriptive Statistik. Dtsch Arztebl Int 2009; 106: 578-583. PubMed

- du Prel J, Hommel G, Röhrig B. Konfidenzintervall oder p-Wert? Dtsch Arztebl 2009; 106: 335-339. doi:10.3238/arztebl.2009.0335 DOI

- Victor A, Elsäßer A, Hommel G. Wie bewertet man die p-Wert-Flut?. Dtsch Arztebl Int 2010; 107: 50-56. doi:10.3238/arztebl.2010.0050 DOI

- Röhrig B, du Prel J, Wachtlin D, et al. Fallzahlplanung in klinischen Studien. Dtsch Arztebl Int 2010; 107: 552-556. doi:DOI: 10.3238/arztebl.2010.0552 DOI

Autoren

- Michael Handke, Prof. Dr. med., Facharzt für Innere Medizin, Kardiologie und Intensivmedizin, Freiburg i. Br.

- Terje Johannessen, professor i allmennmedisin, Institutt for samfunnsmedisinske fag, Norges teknisk-naturvitenskapelige universitet, Trondheim